26 sept. 22

Temps de lecture estimé :min

Entre éthique et lois, qui peut gouverner les systèmes d’intelligence artificielle ?

Nous avons tous commencé à réaliser que le développement si rapide de l’IA allait vraiment modifier le monde dans lequel nous vivons. L’IA n’est plus seulement une branche de la science informatique, elle s’est échappée des labos de recherche avec le développement des « systèmes d’IA », des « logiciels qui, pour des objectifs définis par l’homme, génèrent des contenus, des prédictions, des recommandations ou des décisions influençant les environnements avec lesquels ils interagissent » (définition de l’Union européenne).

Les enjeux de la gouvernance de ces systèmes d’IA – avec toutes les nuances de l’éthique, du contrôle, de la régulation et de la réglementation – sont devenus cruciaux, car leur développement est aujourd’hui aux mains de quelques empires numériques comme les Gafa-Natu-Batx… qui sont devenus les maîtres de véritables choix de société sur l’automatisation et sur la « rationalisation » du monde.

Le tissu complexe croisant l’IA, l’éthique et le droit se construit alors dans des rapports de force – et de connivence – entre les états et les géants de la tech. Mais l’engagement de citoyens devient nécessaire, pour faire valoir d’autres impératifs qu’un solutionnisme technologique où « tout ce qui pourra être connecté sera connecté et rationalisé ».

Une éthique de l’IA ? Les grands principes dans l’impasse

Certes, les trois grands principes éthiques permettent de comprendre comment une véritable bioéthique a pu se construire depuis Hippocrate : la vertu personnelle de « prudence critique », ou la rationalité de règles qui doivent pouvoir être universelles, ou l’évaluation des conséquences de nos actes vis-à-vis du bonheur général.

[Plus de 80 000 lecteurs font confiance à la newsletter de The Conversation pour mieux comprendre les grands enjeux du monde. Abonnez-vous aujourd’hui]

Pour les systèmes d’IA, ces grands principes ont aussi été la base de centaines de comités d’éthique : serment Holberton-Turing, déclaration de Montréal, déclaration de Toronto, Programme de l’Unesco… et même Facebook ! Mais les chartes d’éthique de l’IA n’ont jamais encore débouché sur un mécanisme de sanction, ou même la moindre réprobation.

D’une part, la course aux innovations numériques est indispensable au capitalisme pour surmonter les contradictions dans l’accumulation de profit et elle est indispensable aux états pour développer la gouvernementalité algorithmique et un contrôle social inespéré.

Mais d’autre part, les systèmes d’IA sont toujours à la fois un remède et un poison (un pharmakon au sens de Bernard Stiegler) et ils créent donc continuellement des situations éthiques différentes qui ne relèvent pas de principes mais exigent une « pensée complexe » ; une dialogique au sens de Edgar Morin, comme le montre l’analyse des conflits éthiques autour de la plate-forme de données de santé Health data hub.

Un droit de l’IA ? Une construction entre régulation et réglementation

Même si de grands principes éthiques ne seront jamais opérationnels, c’est de leur discussion critique que peut émerger un droit de l’IA. Le droit se heurte en effet ici à des obstacles particuliers, notamment l’instabilité scientifique de la définition de l’IA, l’aspect extraterritorial du numérique mais aussi la rapidité avec laquelle les plates-formes développent de nouveaux services.

Dans un développement du droit de l’IA, on peut alors voir deux mouvements parallèles. D’une part, une régulation par de simples directives ou recommandations pour une intégration juridique progressive de normes (de la technique vers le droit, telle la certification en cybersécurité). D’autre part, une véritable réglementation par une législation contraignante (du droit positif vers la technique, tel le règlement RGPD sur les données personnelles).

Rapports de force… et connivences

Les données personnelles sont souvent décrites comme un nouvel or noir très convoité, car les systèmes d’IA ont un besoin crucial de données massives pour alimenter l’apprentissage statistique.

En 2018, le RGPD est devenu une véritable régulation européenne de ces données qui avait pu profiter de deux grands scandales, le programme d’espionnage Prims de la NSA et celui des données Facebook détournées chez Cambridge Analytica. Le RGPD a même permis à l’avocat militant Max Schrems en 2020 de faire invalider tous les transferts de données personnelles aux États-Unis par la Cour de justice de l’Union européenne. Mais les rapports de connivence entre états et géants du numérique restent nombreux : Joe Biden et Ursula von der Leyen n’ont de cesse de réorganiser ces transferts de données contestés par une nouvelle régulation.

Les monopoles Gafa-Natu-Batx orientent aujourd’hui le développement des systèmes d’IA : ils contrôlent les futurs possibles par les « machines prédictives » et la manipulation de l’attention, ils imposent la complémentarité de leurs services et bientôt l’intégration de leurs systèmes dans l’Internet des objets. Les états réagissent à cette concentration.

Aux États-Unis, un procès pour obliger Facebook à revendre Instagram et WhatsApp va s’ouvrir en 2023, et une modification de la législation antitrust va être votée.

En Europe à partir de 2024, le règlement sur les marchés numériques, l’acte DMA, encadrera les acquisitions et interdira aux « grands contrôleurs d’accès » l’autoréférencement ou les offres groupées entre leurs différents services. Quant au règlement sur les services numériques, l’acte DSA, il obligera les « grandes plates-formes » à une transparence sur leurs algorithmes, à une gestion rapide des contenus illégaux et il interdira la publicité ciblée sur des caractéristiques sensibles.

Mais les connivences restent fortes, car chacun protège aussi « ses » géants en brandissant la menace chinoise. Ainsi sous les menaces de l’administration Trump, le gouvernement français avait suspendu le paiement de sa « taxe Gafa » pourtant votée par le parlement en 2019 et les tractations fiscales continuent dans le cadre de l’OCDE.

Une réglementation européenne nouvelle et originale sur les risques spécifiques des systèmes d’IA

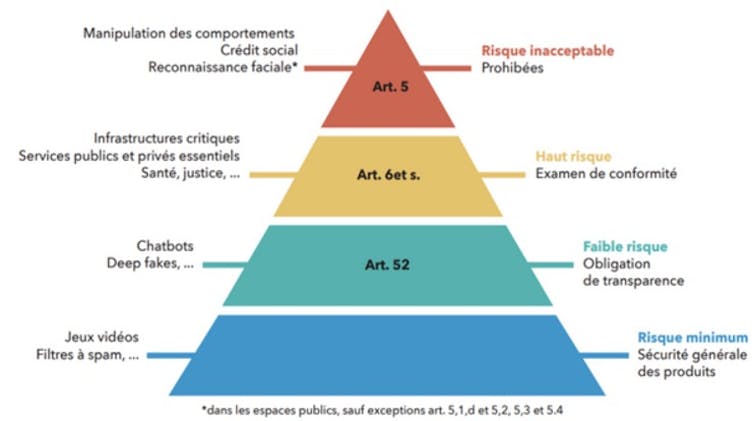

Les progrès spectaculaires dans la reconnaissance de formes (aussi bien sur les images, que sur les textes, les voix ou les localisations) créent des systèmes de prédiction qui présentent des risques croissants sur la santé, la sécurité ou les droits fondamentaux : manipulations, discriminations, contrôle social, armes autonomes… Après le règlement chinois sur la transparence des algorithmes de recommandations en mars 2022, l’adoption de l’acte AIA, règlement européen sur l’intelligence artificielle, sera une nouvelle étape en 2023.

Cette législation originale est basée sur le degré de risque des systèmes d’IA, dans une approche pyramidale semblable aux risques nucléaires : inacceptable, haut risque, faible risque, risque minimum. À chaque niveau de risque sont associés des interdits, des obligations ou des exigences, qui sont précisées en annexes et qui font encore l’objet de négociations entre le Parlement et la Commission. La conformité et les sanctions seront contrôlées par les autorités nationales compétentes et le Comité européen de l’intelligence artificielle.

Un engagement de citoyens pour un droit de l’IA

À ceux qui considèrent comme une utopie l’engagement de citoyens dans la construction d’un droit de l’IA, on peut d’abord rappeler la stratégie d’un mouvement comme Amnesty International : faire avancer le droit international (traités, conventions, règlements, tribunaux sur les droits humains) pour ensuite l’utiliser dans des situations concrètes comme celle du logiciel espion Pegasus ou de l’interdiction des armes autonomes.

Un autre exemple réussi est celui du mouvement None of your Business (ce n’est pas votre affaire) : faire avancer le droit européen (RGPD, Cour de justice de l’Union européenne…) en déposant tous les ans des centaines de plaintes contre les pratiques de violation de la vie privée par les entreprises du numérique.

Tous ces collectifs de citoyens, qui s’emploient à construire et à se servir d’un droit de l’IA, ont des formes et des démarches très diverses. Depuis les associations européennes de consommateurs qui portent plainte ensemble contre la gestion des comptes Google, jusqu’aux saboteurs d’antennes 5G qui refusent la numérisation totale du monde, en passant par les habitants de Toronto qui font échouer le grand projet de smart city Google ou les médecins militants du logiciel libre qui veulent protéger les données de santé…

Cette mise en avant de différents impératifs éthiques, à la fois opposés et complémentaires, correspond bien à la pensée complexe de l’éthique proposée par Edgar Morin, en acceptant les résistances et les perturbations comme inhérentes au changement.![]()

Bernard Fallery, Professeur émérite en systèmes d'information, Université de Montpellier